orthogonal projection

- High Dimensional Data

- Projection

- Orthogonal Projection: One Dimensional Subspace

- Orthogonal Projection: General Subspace

- Gram-Schmidt Orthogonalization

- Projection onto Affine Space

High Dimensional Data

고차원의 데이터를 분석하거나 시각화하는 것은 힘든 일이다. 따라서 고차원의 데이터를 다룰 때, 종종 고차원의 데이터를 저차원으로 projection 시켜서 작업을 한다. 하지만, 이렇게 저차원으로의 projection은 필연적으로 정보 손실을 가져오게 되는데, 이때, 정보손실을 최소화하면서 projection을 시키는 것이 중요하다.

Projection

- $V$: vector space

- $U \subset V$: vector subspace of V

- $\pi$: linear mapping

linear mapping은 matrix형태로 나타낼 수 있기 때문에, projection은 다음과 같이 표현할 수 있다. 그리고 projection matrix는 다음과 같은 조건을 만족해야한다.

Orthogonal Projection: One Dimensional Subspace

이 책에서는 주로 orthogonal projection에 대해서 다룬다. 이유에 대해서 생각해보면, compression loss를 최소화할 수 있는 방법이기 때문!

우선, 1차원의 vector subspace에 projection 시키는 문제에 대해서 정리해볼 계획이다.

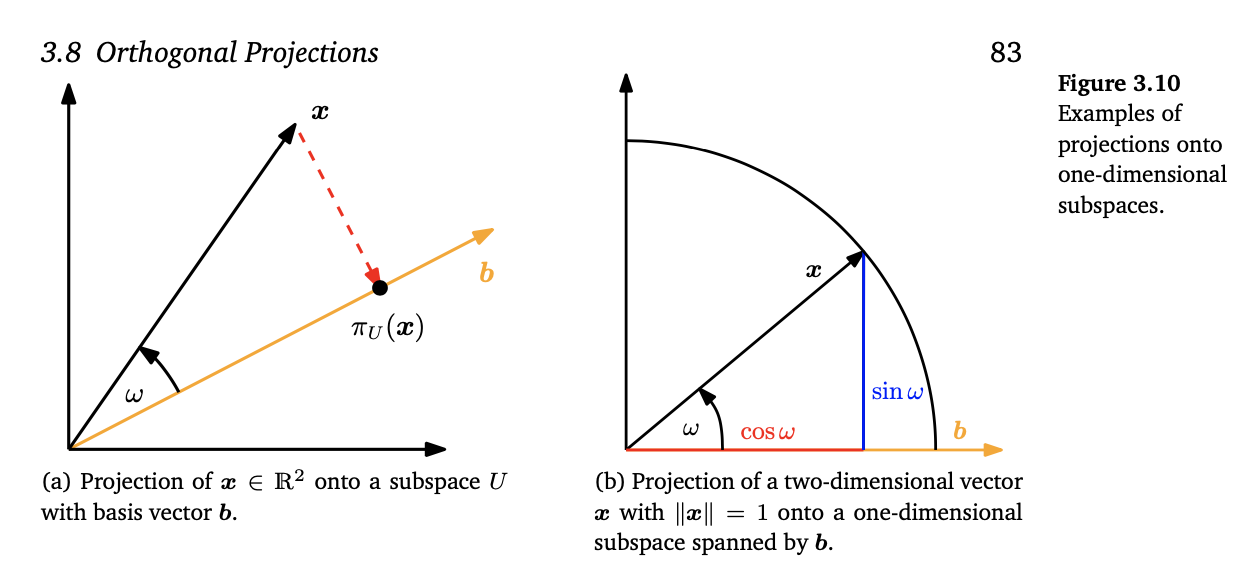

subspace $U \in V$는 위의 (a)에서 노란색 라인을 의미한다. 이 때, basis는 $b \in U$이다. 그리고 $x \in V$는 이제 앞으로 subspace U에 projection 할 것이고, 이를 $\pi_U{x}$라고 표현한다. ($V \in R^2$)

-

$\Pi_U{x}$ 는 $x$와 vector subspace U내에서 가장 가까운 점이다. 가장 가깝다라는 것의 수학적인 의미는 $\rVert x - \pi_U(x)\rVert$가 가장 작다는 뜻이며, 이는 distance vector $ x - \pi_U(x)$가 $U$와 orthogonal하다는 것이다.

-

$\pi_U(x)$는 U내에 존재해야한다.

앞서서 orthogonal projection한 결과가 어떤 특징을 가지는지 살펴봤다. 이제는 어떤식으로 구하는지 살펴보겠다.

앞의 식을 다음과 같이 변경할 수 있다.

$\lambda$에 대해서 구했으니, 이를 $\pi_U$에 대해서 적용해보겠다. $\pi_U(x) = \lambda b $은 직관적으로는 projection 함수의 결과가 U에서의 coordinate라는 것을 알 수 있다.

그리고 이를 cosine으로 나타내면 다음과 같다. (b) 참고

Orthogonal Projection: General Subspace

이제 general한 orthogonal projection에 대해서 알아볼 것이다. 이제 projection 되는 공간은 $U \in R^k, k > 1$이다.

- $B = [b_1, b_2, \cdots, b_k\ ] \in R^{nk}$

- $\lambda = [\lambda_1, \lambda_2, \cdots, \lambda_k] \in R^k$

이를 조금 matrix로 표현하면 다음과 같다.

위에서 마지막 식은 normal equatioin*이라고 한다. 또한 B는 basis로 이루어진 matrix이기 때문에 $B^T B$는 regular하며, invertable하다. 이제 다시 projection을 정리해보겠다. 이를 바탕으로 projection matrix $P_{\pi}$를 구해보면 다음과 같다. 직관적으로 projection을 하게 되면, 기존의 m차원의 공간의 vector를 n차원을 vector로 표현할 수 있게 된다. 이러한 점을 활용하여, linear equation $Ax = b$의 해가 없을 때, 근사하여 구할 수 있다.

$Ax = b$의 해가 없다는 것은 $b$가 A의 basis로 span되는 공간에 없다는 것이다. 하지만, A의 span되는 공간에서 b와 가장 가까운 점을 구할 수 있는데, 이 해를 least square solution이라고 한다.

Remark: orthonormal basis

Subspace U의 basis가 orthonormal basis라면,

- $(B^TB) ^(-1) = I$

따라서 불필요하게 inverse를 구할 필요가 없다.

Gram-Schmidt Orthogonalization

Gram-schmidt orthogonalization은 어떤 basis는 orthogonal/orthonormal basis로 바꿔준다. 또한 orthogonal basis는 항상 존재하며, span되는 공간은 변하지 않는다.

다음과 같은 과정을 통해서 gram-schmidt orthogonalization이 진행된다.

- basis: $[b_1, b_2, \cdost, b_n]$

- orthogonal basis: $u_1, u_2, \cdots, u_n$

Projection onto Affine Space

아직까지 vector subspace상에서의 projection을 다뤘다. 그럼 affine space상으로의 projection은 어떻게 진행될지 살펴보겠다.

위의 이미지에서 (a)는 affine space $L = x_0 + U$과 vector subspace U의 basis b1, b2가 나타나있다. 여기서 x vector의 L space상으로의 projection은 다음과 같이 나타낼 수 있다. 위의 문제를 풀기 위해서, 기존의 vector subspace상에서의 projection을 활용한다. 이를 위해서 $x - x_0$을 vector subspace U에 projection시킨다. 이 것의 의미는 U와 L사이의 관계를 생각해보면 이해하기 쉽다. L은 U로 부터 $x_0$만큼 이동한 공간이다. 따라서 x가 L에 projection되는 위치는 $x - x_0$이 U에 projection되는 위치에 x_0을 더한 것과 같다. 따라서, Remark